Feliz año nuevo!!!!!! Os deseo lo mejor para este 2009 que llega.

- Notes -

Handle 0x004A

DMI type 16, 15 bytes.

Physical Memory Array

Location: System Board Or Motherboard

Use: System Memory

Maximum Capacity: 65024 MB

Number Of Devices: 12

Handle 0x004B

DMI type 17, 27 bytes.

Memory Device

Size: 512 MB

Form Factor: DIMM

Set: 1

Locator: DIMM 1

Bank Locator: Bank 1

Speed: 266 MHz (3.8 ns)

Handle 0x004C

DMI type 17, 27 bytes.

Memory Device

Size: 512 MB

Form Factor: DIMM

Set: 3

Locator: DIMM 4

Bank Locator: Bank 1

Speed: 266 MHz (3.8 ns)

...

Handle 0x004F

DMI type 17, 27 bytes.

Memory Device

Size: 2048 MB

Form Factor: DIMM

Set: 3

Locator: DIMM 3

Bank Locator: Bank 5

Speed: 266 MHz (3.8 ns)

Handle 0x0055

DMI type 17, 27 bytes.

Memory Device

Size: No Module Installed

Form Factor: DIMM

Set: 4

Locator: DIMM 9

Bank Locator: Bank 6

Speed: 266 MHz (3.8 ns)

El volumen de SPAM mundial se desplomó el pasado martes 11 de Noviembre después de que una empresa de hosting, fue puesta fuera de línea.

La caída en el volumen de spam se debe a que los proveedores de Internet (ISPs) desconectaron a McColo Corp (un proveedor de hosting de California que alojaba los servidores responsables del envío de aproximadamente el 75% de todo el spam mundial diario.)

Prueba de ello es la grafica que se ve en los servidores de correo entrante (spam linea naranja, trafico normal linea azul):

Os dejo un link que he encontrado interesante sobre el parcheo de servidores ESX:

Os dejo un link que he encontrado interesante sobre el parcheo de servidores ESX:

Target: VirtualMachine1

Old Status: Green

New Status: Yellow

Current value:

Alarma Virtual Machine - (Metric CPU Usage (Average/Rate) = 76% OR Metric Memory Usage (Average/Absolute) = 12% OR Metric Network Usage (Average/Rate) = 0% OR Metric Disk Usage (Average/Rate) = 0% OR State = Powered On)

Alarm: Alarma Virtual Machine

([Yellow Metric Is Above 75%; Red Metric Is Above 90%] OR [Yellow Metric Is Above 75%; Red Metric Is Above 90%] OR [Yellow Metric Is Above 75%; Red Metric Is Above 90%] OR [Yellow Metric Is Above 75%; Red Metric Is Above 90%] OR [Yellow State Is Equal To suspended; Red State Is Equal To poweredOff])

Description:

Alarm Alarma Virtual Machine on VirtualMachine1 changed from Green to Yellow

Como vemos, el error esta en el registro EAX del nivel 1. Para arreglarlo anotamos el valor del registro de los servidores incompatibles entre sí y vemos la mascara por defecto que tienen nuestras VMs (Edit Settings, Pestaña Options, Advanced, y en CPU Identification Mask pinchar en Advanced).

Como vemos, el error esta en el registro EAX del nivel 1. Para arreglarlo anotamos el valor del registro de los servidores incompatibles entre sí y vemos la mascara por defecto que tienen nuestras VMs (Edit Settings, Pestaña Options, Advanced, y en CPU Identification Mask pinchar en Advanced).

Server1 Level1 EAX: 0000 0000 0000 0000 0000 0000 0000 0110Como podemos ver sólo nos interesa los bytes segundo, tercero y sexto(los demas llevan X asi que lo podemos dejar por defecto). En el caso del segundo y tercero byte, vemos que son iguales, luego no tenemos que hecer nada. En el caso del sexto vemos que los bits del medio son diferentes asi que los enmascaramos.

Server2 Level1 EAX: 0000 0000 0000 0000 0000 0110 1111 0110

Standard CPU Mask Level1 EAX: XXXX HHHH HHHH XXXX XXXX HHHH XXXX XXXX

Custom CPU Mask Level1 EAX: ---- ---- ---- ---- ---- -00- ---- ----

Effective CPU Mask Level1 EAX: XXXX HHHH HHHH XXXX XXXX H00H XXXX XXXX

Muy buenas a todos, después de unas más que merecidas vacaciones y la vuelta a trabajar un tanto intensa que he tenido, por fin tengo un huequillo para escribir.

Muy buenas a todos, después de unas más que merecidas vacaciones y la vuelta a trabajar un tanto intensa que he tenido, por fin tengo un huequillo para escribir.

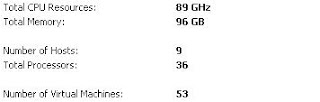

2.- Consolidar con VMware los 10 servidores fisicos en 3 servidores con almacenamiento local: Tres HP ML350 (con mas memoria que los anteriores y almacenemiento en local RAID5) con VMware ESX (licencias incluidas).

Coste: 49,300$

3.- Los mismos servidores de Virtualizacion en un Cluster que usa una SAN de 1 TB: Tres HP ML350, con mas memoria que los primeros, discos de arranque, VMware ESX Enterprise y una SAN Hitachi de 1TB.

Coste: 52.730$

A la vista del experimenteo que ha llevado a cabo Krick, vemos que, nos ahorraríamos 12.000$, si usamos la virtualizacion y que, además por unos 3.400$ más que la opcion más barata(la 2), tendremos una SAN.

Es verdad que incrementa costes respecto a la opcion 2, pero (por unos 3.400$) nos deja opciones como redundancia, snapshots, thin provisioning y mejor rendimiento, además de que nos permita operaciones tan utiles como Vmotion, DRS, HA, etc, etc...

Realmente, si hacemos un ejercicio similar(ojo, comparando cosas similares), veremos que es algo que realmente merece la pena.